Marketing statt Medizin: KI-Augen-Screenings unter der Lupe

Augenvorsorge ist ein zentrales Instrument, um Erkrankungen der Netzhaut frühzeitig zu erkennen und rechtzeitig zu behandeln. Viele dieser Erkrankungen – etwa die altersbedingte Makuladegeneration (AMD), das Glaukom oder die diabetische Retinopathie (DR) – führen unbehandelt zu Sehverlust oder Erblindung. Einige Netzhauterkrankungen können aber bei rechtzeitiger Diagnose abgeschwächt, verzögert oder sogar verhindert werden. Die Deutsche Ophthalmologische Gesellschaft (DOG) und der Bundesverband der Augenärzte (BVA) empfehlen deshalb allen Menschen ab dem 40. Lebensjahr, regelmäßig eine Vorsorgeuntersuchung durchführen zu lassen. In der Praxis stößt dieses Ideal jedoch auf zwei zentrale Hürden: Zum einen sind die augenärztlichen Kapazitäten in Europa so begrenzt, dass eine flächendeckende Umsetzung schlicht nicht realistisch ist. Zum anderen handelt es sich in Deutschland um eine sogenannte IGeL-Leistung, die bis über 100 Euro kosten kann – für viele ein zu hoher Betrag, um die Untersuchung aus eigener Tasche zu bezahlen.

In den letzten Jahren haben daher immer mehr Optiker und Optometristen begonnen, Netzhautscreenings anzubieten. Das ist im Prinzip eine sinnvolle Entwicklung, denn die strukturellen Engpässe bei Augenärzten lassen sich aufgrund der Demographie nur in einem Zeithorizont von Jahrzehnten lösen. Die entscheidende Frage ist jedoch, wie im Setting beim Optiker oder Optometrist eine medizinisch adäquate Qualität gewährleistet werden kann. Grundsätzlich gibt es zwei Ansätze: telemedizinische Lösungen, bei denen die Aufnahmen der Netzhaut im Geschäft erstellt, aber von Augenärzten aus der Ferne beurteilt werden, und KI-gestützte Systeme, bei denen die Software direkt vor Ort einen Befund liefert. Telemedizinische Modelle sind in Ländern wie Schweden oder Norwegen seit Jahren etabliert und gut dokumentiert. Der zweite Ansatz – der direkte Einsatz von KI beim Optiker – drängt nun verstärkt auch in der DACH-Region auf den Markt.

Ich bin kein Gegner dieser Technologie – im Gegenteil: Ich habe jahrelang zu medizinischen KI-Systemen geforscht und bin überzeugt, dass in absehbarer Zeit ein Großteil der bildgebenden Diagnostik ohne Qualitätsverlust automatisiert durch KI erfolgen kann. Jedoch sind die aktuell in Europa zugelassenen KI-Systeme schlichtweg nicht für allgemeines Netzhautscreening geeignet.

Problem 1: Viele Krankheiten können nicht erkannt werden

Die zugelassenen KI-Systeme für Fundusbilderkennung sind in der Regel auf drei Krankheitsbilder beschränkt: AMD, Glaukom und DR. Das heißt, eine Vielzahl anderer potenziell gefährlicher Befunde – etwa Netzhautablösungen, Gefäßverschlüsse, Entzündungen oder Tumoren – wird nicht erkannt. Das wissen wir, da die Hersteller bei der Zulassung als Medizinprodukt genau angeben müssen wofür sie ausgelegt sind. Wenn ein Hersteller also angibt, dass drei Krankheiten erkannt werden können, kann man davon ausgehen dass andere Krankheiten nicht erkannt werden.

Auch wir bei Ocumeda bieten telemedizinische Augen-Check-Ups durch Augenärzte an. Hierbei sind ca. 22% der Untersuchungen auffällig und ungefähr die Hälfte der auffälligen Untersuchungen fallen weder auf AMD, Glaukom noch DR. Diese Zahlen basieren auf unserer eigenen Datenbasis aus über 200.000 telemedizinischen Untersuchungen in der DACH-Region. Unter den Befunden finden sich Gefäßverschlüsse, Makulaödeme, hypertensive Retinopathien, Netzhautablösungen, Tumore und viele weitere. Diese sind durch die aktuell zugelassenen KI-Systeme nicht erkennbar.

Dies zeigt deutlich, dass ein reines „Drei-Krankheiten-Screening“ einen relevanten Anteil auffälliger Befunde übersieht. Ein solches System als „Netzhautscreening“ oder gar „Augen-Check-up“ zu bezeichnen, ist irreführend und kann im Kontext der MDR (Medical Device Regulation) sogar rechtlich problematisch werden. Treffender wäre: „Check-up auf AMD, Glaukom und DR“.

Problem 2: Beim Screening in einer überwiegend asymptomatischen Population kann die KI nur versagen

Hinzu kommt ein statistisches Problem, das unabhängig von der Qualität des Algorithmus gilt: In einer asymptomatischen Bevölkerungsgruppe, wie sie bei Optiker-Kunden in einer Fußgängerzone zu erwarten ist, ist die Prävalenz dieser Erkrankungen niedrig und sehr altersabhängig. Je nach Quelle variiert die Prävalenz der (diagnostizierten) AMD zwischen 0,96% und 3,5%. Wir nehmen für unsere Rechnung hier 3% an – und das ist bereits eine optimistische Annahme, die ältere Menschen stärker gewichtet. Bei jüngeren Zielgruppen ist sie noch deutlich geringer, was die mathematische Situation weiter verschärft. Außerdem nehmen wir optimistisch an, dass die Herstellerangaben zu Sensitivität und Spezifität der KI-Systeme in diesem realen Setting unverändert gelten (was keineswegs garantiert ist).

Neben der Sensitivität (Anteil der tatsächlich erkrankten Personen, die der Test korrekt als positiv erkennt) und der Spezifität (Anteil der gesunden Personen, die der Test korrekt als negativ erkennt) ist der Positive Predictive Value (PPV, positiver Vorhersagewert) ein entscheidender Kennwert. Er gibt die Wahrscheinlichkeit an, dass eine Person mit positivem Testergebnis tatsächlich erkrankt ist, und hängt nicht nur von Sensitivität und Spezifität, sondern auch von der Prävalenz der Erkrankung in der getesteten Population ab. Die Formel für den PPV zeigt, dass bei niedriger Prävalenz selbst eine hohe Sensitivität und Spezifität nicht verhindern, dass falsch-positive Befunde überwiegen:

\( PPV = \frac{\text{Sensitivität} \times \text{Prävalenz}}{\text{Sensitivität} \times \text{Prävalenz} + (1-\text{Spezifität}) \times (1-\text{Prävalenz})} \)

Glücklicherweise veröffentlichen einige KI-Anbieter die Performance ihrer Systeme, anhand derer wir den zu erwartenden PPV im Screening-Setting berechnen können. Wir nehmen für unser Rechenbeispiel die Daten für die Erkennung von AMD. Man könnte die Rechnung auch für Glaukom oder DR machen - aber qualitativ sind die Ergebnisse die gleichen. Ebenso könnte man die Daten von anderen Herstellern herannehmen. Ich habe hier aber bewusst die beiden Hersteller ausgewählt deren medizinische Qualität ich als am höchsten und am transparentesten publiziert einschätze.

Beispiel Thirona Retina

Die von Thirona Retina veröffentlichten Werte für AMD liegen bei 93% Sensitivität und 90% Spezifität. Bei einer Prävalenz von 3% ergibt das einen PPV von nur 22,3% – vier von fünf positiven Ergebnissen sind also Fehlalarme.

Beispiel OphtAI

Für ein anderes System (OphtAI) mit 92,5% Sensitivität und 87% Spezifität fällt der PPV auf 18%. Mehr als vier von fünf positiven Ergebnissen sind Fehlalarme. In beiden Fällen ist klar: Die überwiegende Mehrheit der „erkannten Erkrankungen“ ist keine.

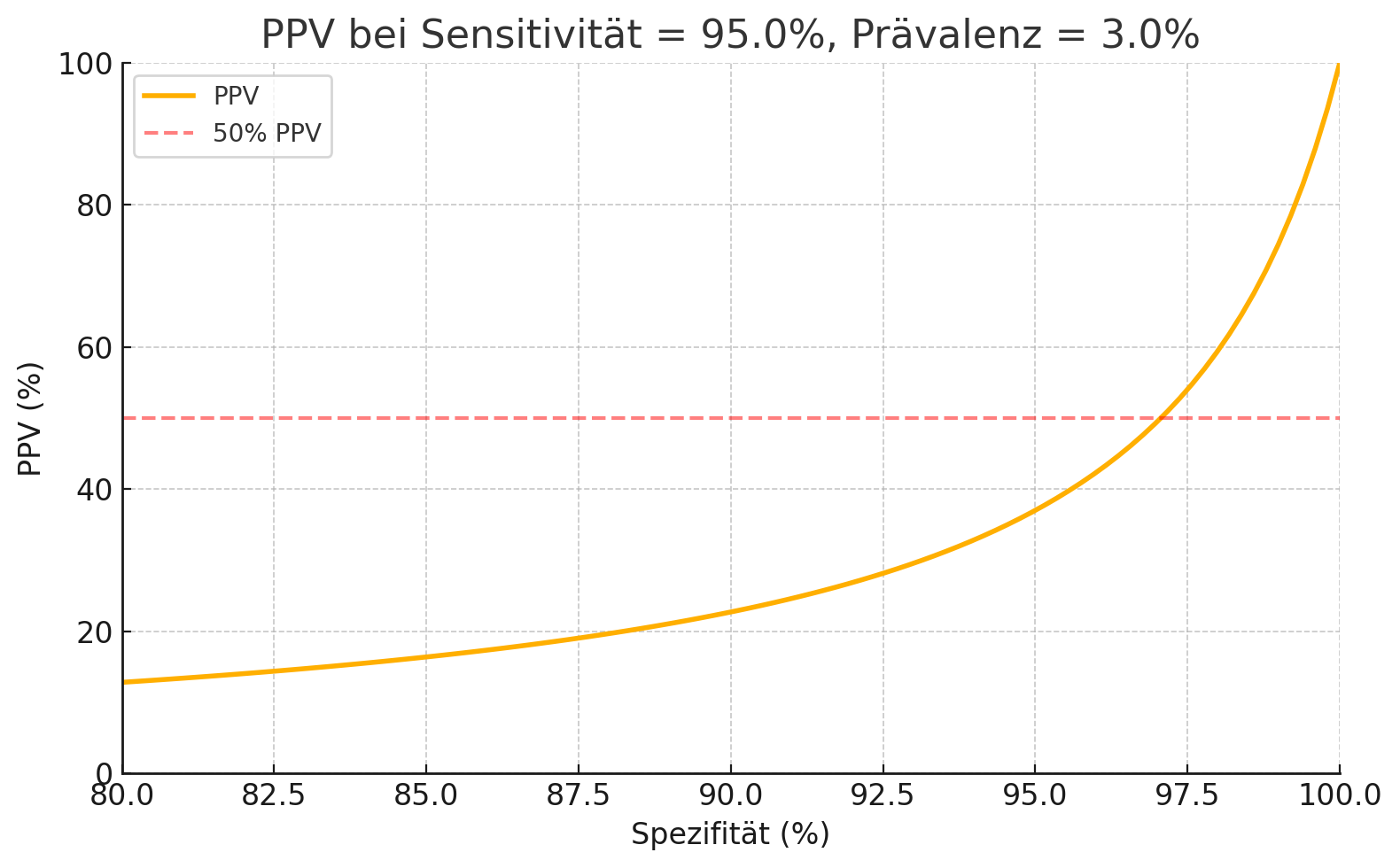

Zur Illustration des Problems sehen wir in der folgenden Grafik den PPV bei einer festgesetzten Sensitivität von 95% als Funktion der Spezifität.

Bei einer Prävalenz von 3% steigt der PPV erst jenseits von ca. 97% Spezifität über 50%. In der Realität erreicht nach meinem Wissen keine derzeit in Europa zugelassene AMD-Screening-KI auch nur annähernd diese Spezifitätswerte bei gleichbleibend hoher Sensitivität. Jeder falsche Alarm belastet die ohnehin knappen augenärztlichen Kapazitäten, sorgt für unnötige Sorge bei Patienten und verärgert die Augenärzte. Das führt nicht nur zu Reputationsverlust durch fehlerhafte Überweisungen, sondern auch zu frustrierten Patienten, die Zeit und Nerven verlieren.

Ist eine ärztliche Validierung der KI sinnvoll?

Einige Anbieter werben damit, dass ihre KI-Ergebnisse „ärztlich validiert“ werden. Damit ist in der Regel gemeint, dass ein Augenarzt das von der KI gelieferte Resultat auf Plausibilität prüft und gegebenenfalls korrigiert. Dieses Vorgehen kann zwar die Zahl der Fehlalarme reduzieren und grobe Fehlklassifikationen bei den drei erkannten Krankheitsbildern (AMD, Glaukom, DR) abfangen, ändert jedoch nichts an der grundsätzlichen Limitierung des Systems: Pathologien, die außerhalb dieses engen Spektrums liegen – etwa Netzhautablösungen, Gefäßverschlüsse, Entzündungen oder Tumoren – werden von der KI nicht als auffällig markiert und gelangen somit auch nicht in die ärztliche Validierung. Problem 1 bleibt daher vollständig bestehen: Das Verfahren deckt weiterhin nur einen Teil relevanter Augenerkrankungen ab und kann kein allgemeines Screening ersetzen.

KI ist nicht per se schlecht - aber die falsche KI in der falschen Population führt zu großen Problemen

Das alles heißt nicht, dass KI im Netzhautscreening keine sinnvolle Rolle spielen kann. Richtig eingesetzt – etwa bei Zielgruppen mit hoher Prävalenz, wie Diabetikern beim DR-Screening – kann sie eine große Entlastung bringen. In den USA setzt etwa Digital Diagnostics/IDX seit Jahren mit Erfolg auf dieses Modell. Der entscheidende Unterschied ist hier, dass es beim Screening explizit um diabetische Retinopathie geht und die Prävalenz von DR in dieser Gruppe bei ca. 25% liegt, was wiederum deutlich bessere PPV zur Folge hat.

Ein anderer sinnvoller Ansatz könnte sein, ein KI-System nicht auf die Erkennung bestimmter Pathologien auszulegen (deren Prävalenz beim allgemeinen Screening immer gering ist), sondern Fälle, die eine weitere Abklärung beim Augenarzt erfordern von unauffälligen Fällen zu unterscheiden. Dann läge die Prävalenz basierend auf den Ocumeda-Daten bei ca. 22% und der PPV würde sich dadurch wieder in einem akzeptablen Bereich bewegen.

Fazit

Für den Einsatz als allgemeiner „Augen-Check-up“ bei einer überwiegend asymptomatischen Population in der Fußgängerzone sind aktuelle KI-Systeme ungeeignet. Sie verursachen sogar Schaden – einerseits am Menschen durch übersehene Erkrankungen, andererseits am Gesundheitssystem durch zu viele Fehlalarme. Das ist keine Frage der Meinung, sondern eine Folge klarer mathematischer und medizinischer Logik.